Openclaw如何对接本地大模型?

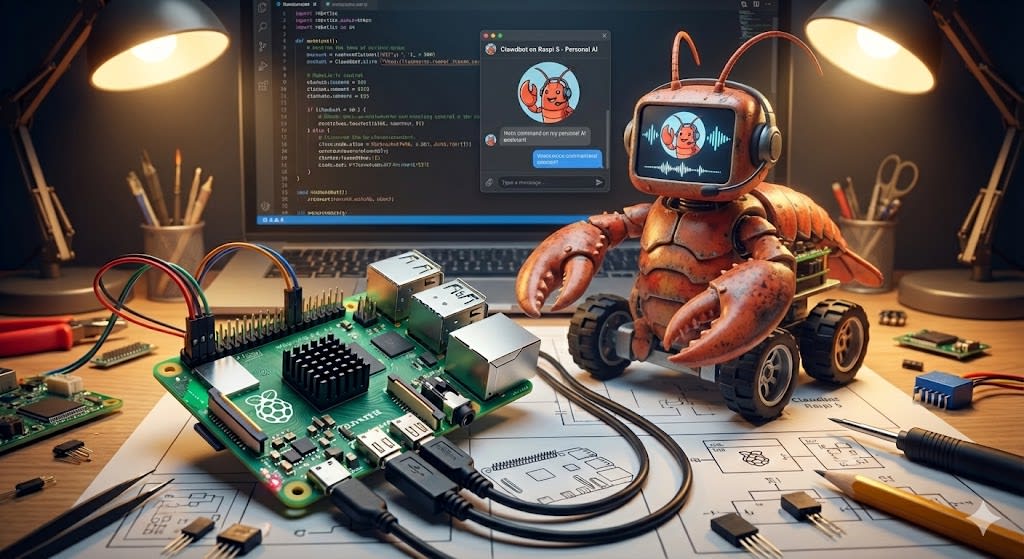

OpenClaw 的本地化部署能够实现真正的隐私安全与零调用成本。通过将 OpenClaw 与 Ollama 或 LM Studio 等本地推理引擎对接,你可以让 AI 智能体在不联网的情况下,依然具备操作文件、执行代码和管理日程的能力。

本文大纲

-

🛠️ 准备工作:安装本地推理引擎(Ollama/LM Studio)

-

🧩 模型选择:适合 Agent 任务的本地模型推荐

-

⚙️ 配置步骤:在 OpenClaw 中接入 OpenAI 兼容接口

-

🧪 连通性测试:确保“大脑”与“肢体”正常通信

1. 准备工作:启动本地引擎 🛠️

在对接 OpenClaw 之前,你需要先在本地运行一个模型服务器。

-

方案 A:Ollama(推荐)

下载并安装 Ollama 后,在终端运行以下命令启动服务:

ollama serve默认监听端口:

11434 -

方案 B:LM Studio

下载并启动 LM Studio,在“Local Server”选项卡中点击 Start Server。

默认监听端口:

1234

2. 模型选择:给 Agent 换颗好大脑 🧩

不是所有本地模型都能胜任 OpenClaw 的任务。由于 Agent 需要频繁调用工具(Function Calling),建议选择经过指令微调的模型:

-

Qwen3-Coder (7B/14B):目前开源界最适合处理代码和逻辑指令的模型之一。

-

DeepSeek-R1-Distill-Llama-8B:推理能力强,适合处理复杂任务拆解。

-

Llama-3.2 (8B):综合性能均衡,响应速度快。

下载命令示例(以 Ollama 为例):

ollama pull qwen2.5-coder:7b

3. 配置步骤:接入 OpenClaw ⚙️

OpenClaw 采用 OpenAI 兼容协议,对接本地模型非常直观。

-

启动配置引导:

执行

openclaw onboard。 -

设置 Provider:

在模型供应商列表中选择

Custom或OpenAI Compatible。 -

填入本地参数:

-

Base URL:

-

若使用 Ollama:

http://localhost:11434/v1 -

若使用 LM Studio:

http://localhost:1234/v1

-

-

API Key: 填入任意字符(本地引擎通常不需要真实 Key,但不能为空,可填

local-key)。 -

Model Name: 填入你下载的具体模型名称(如

qwen2.5-coder:7b)。

-

关键提醒:请确保 OpenClaw 配置文件中的上下文长度(Context Length)设置为至少

32k或64k。Agent 运行过程中会积累大量的工具调用历史,上下文太小会导致 AI “失忆”或报错。

4. 连通性测试:确保通信正常 🧪

配置完成后,通过以下步骤确认链路是否打通:

-

环境检查:运行

openclaw doctor,观察Model Provider是否显示为绿色勾选状态。 -

指令测试:在聊天终端输入:

帮我创建一个名为 test.txt 的文件,并在里面写上“本地模型测试成功”。 -

观察日志:如果本地模型控制台(如 Ollama 窗口)开始滚动输出 Token,且本地文件夹出现了新文件,说明对接成功。

总结

将 OpenClaw 对接到本地大模型,核心在于利用 Ollama 等工具提供的 OpenAI 兼容接口。这种架构不仅消除了昂贵的 API 费用,还确保了敏感数据永远不出本地网络。

相关阅读:

如果你觉得在树莓派或 NAS 等低功耗设备上运行这一套“全本地 AI 助手”过于复杂,那么也有国产平替”无需部署“的方式,下载实在Agent,并关联钉钉/飞书,就可以在手机上远程试用同样的自然语言操控功能,它和openclaw的区别是试用真实的模拟人类操作,帮助你在电脑上干活。

结算核算自动化什么意思?

Openclaw架构是什么?Openclaw架构介绍

智能选品系统有哪些?

Openclaw算力要求高吗?网关和本地要求详解