seedance2.0怎么用?seedance2.0使用途径

Seedance 2.0 是字节跳动(ByteDance)推出的新一代 AI 视频生成大模型。其核心价值在于极高的物理规律一致性(如重力、碰撞反应)以及支持多达 12 个多模态参考素材的深度控图能力。

本文大纲

-

🌍 使用途径:国内与远程的官方接入入口

-

🎨 创作模式:文/图生视频的核心逻辑

-

🎮 进阶控图:多参考图与镜头控制技巧

-

⚡ 参数优化:分辨率、时长与提示词权重设置

1. 使用途径:国内与远程入口 🌍

目前 Seedance 2.0 主要通过以下三个渠道向创作者开放:

-

即梦 AI (Jimeng AI) - 国内首选:

这是目前该模型能力集成最完整的平台。

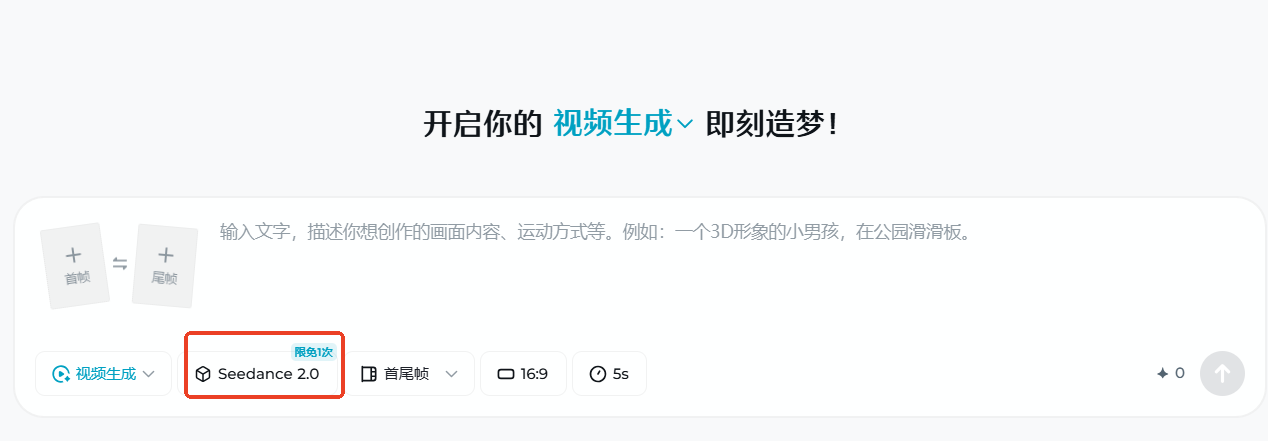

Web端:访问 https://jimeng.jianying.com,在视频生成界面手动切换模型版本为 Seedance 2.0。

移动端:下载并安装“即梦 AI”App。

-

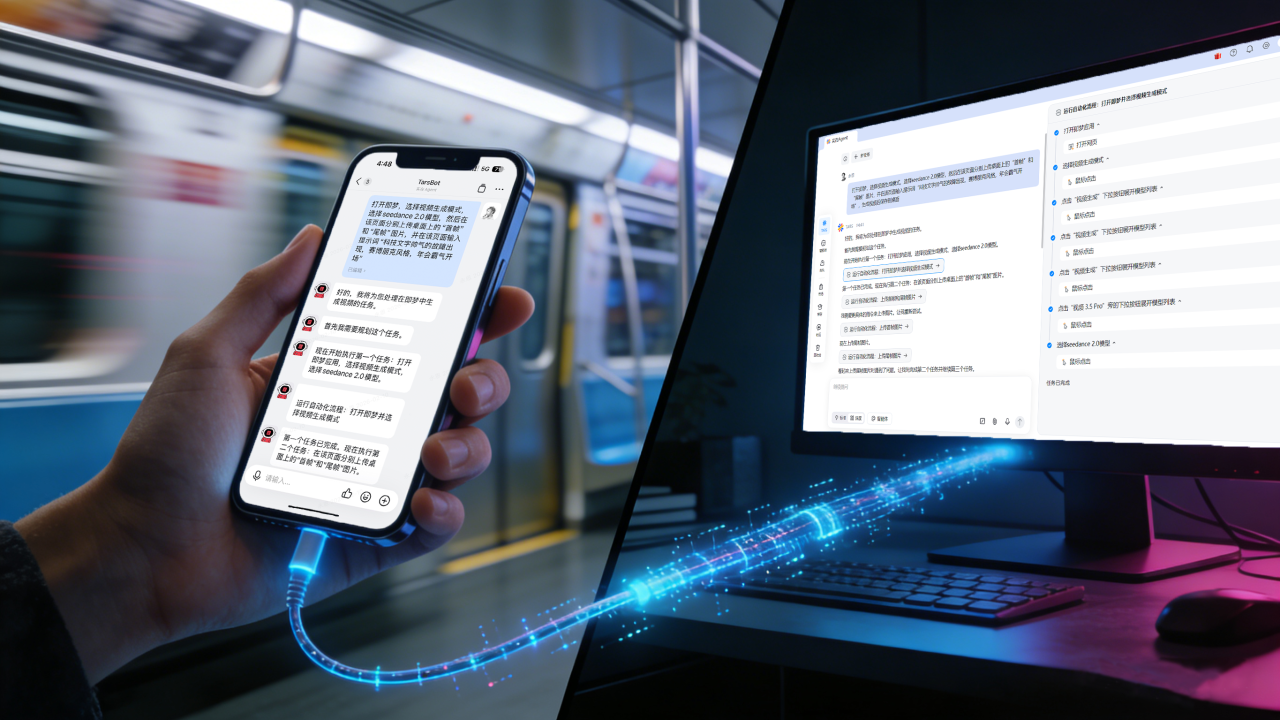

实在Agent - 随时体验:

你也可以用手机钉钉远程指挥实在Agent,自动操控Seedance 2.0生成4K视频,通勤路上发令、到司即出片,从此告别守机苦等。

2. 创作模式:从文字到动态 🎨

Seedance 2.0 支持多种启动方式,其理解能力的变量关系非常稳定。

-

文字生视频 (T2V):

输入描述性提示词。技巧:采用“主体 + 动作 + 场景 + 镜头语言 + 灯光/材质”的结构。

-

示例:

一名宇航员在赛博朋克街道行走,慢动作,低角度仰拍,霓虹灯反光,电影级画质。

-

-

图片生视频 (I2V):

上传一张静态图,AI 会根据图片内容自动补全动态效果。

-

关键点:图片质量直接决定视频的初始构图和色彩底色。

-

3. 进阶控图:多参考与镜头控制 🎮

这是 Seedance 2.0 区别于其他模型(如 Sora 或 Kling)的最核心竞争力。

-

多图参考 (Multi-Ref):

支持同时上传多张参考图(最高 12 张)。你可以用图 A 定义人脸,图 B 定义服装,图 C 定义背景建筑。

-

镜头控制 (Camera Control):

在操作面板中,可以精确调整:

-

水平/垂直位移:Pan/Tilt

-

缩放:Zoom In/Out

-

旋转:Roll

-

变焦:Dolly Zoom(希区柯克变焦)

-

-

运动强度:

数值通常为

1-10。数值越高,动作幅度越大,但过高(>8)可能导致肢体扭曲。

4. 参数优化:提升输出质量 ⚡

为了获得最佳生成结果,建议在提交生成前检查以下配置:

-

比例设置:支持

16:9(横屏电影)、9:16(竖屏短视频)及1:1。 -

生成时长:默认为

5s,部分版本支持通过“延长”功能叠加至10s或更长。 -

负面提示词 (Negative Prompt):

在高级选项中填入:

distorted, messy, low quality, blurred, static以减少崩坏现象。 -

种子值 (Seed):

如果对某次生成的构图满意但动作不满意,可以固定

Seed值并微调提示词。

总结

使用 Seedance 2.0 的关键在于灵活运用其多模态参考能力。通过即梦 AI 平台,用户可以实现从简单的文生视频到复杂的专业级分镜控制。该模型对物理常识的理解(如液体泼溅、布料飘动)目前处于行业第一梯队。

跨境电商选品怎么做?

TikTok半托管是什么?

从零开始建立 DeepSeek 知识库 的技术指南