Codex装什么mcp好用?插件推荐与配置指南

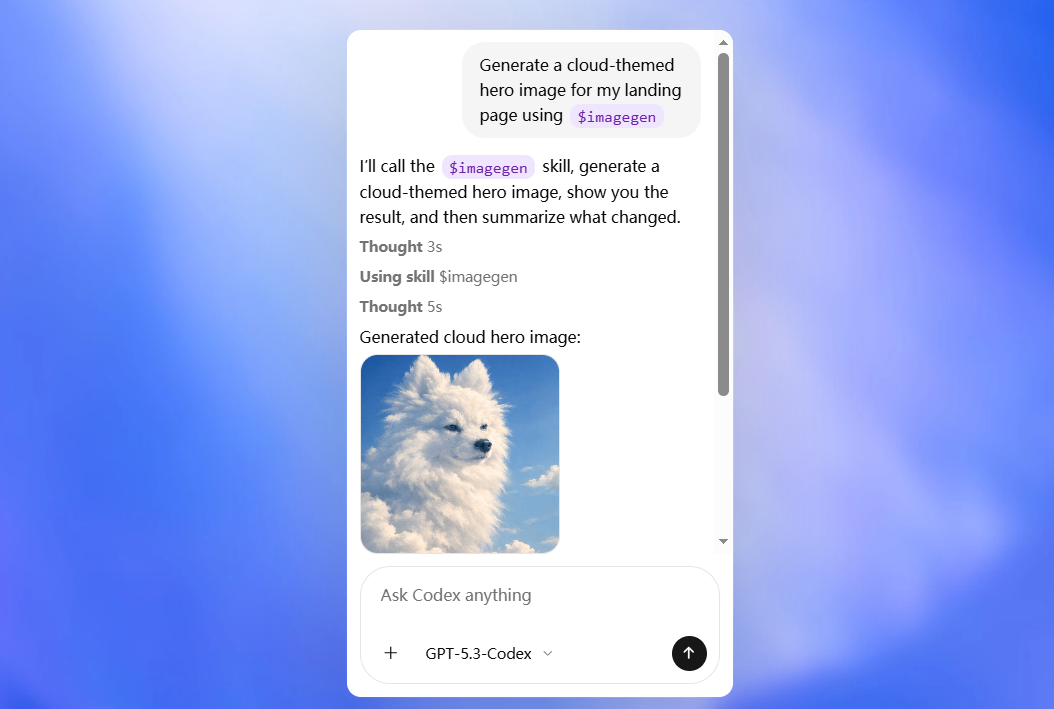

OpenAI Codex 是专为“Agent 式编程”设计的指挥中心。通过接入 MCP (Model Context Protocol),你可以将原本局限于聊天框的 AI,扩展为具备操作本地文件、管理 GitHub 仓库及实时搜索技术文档能力的“全能员工”。

本文大纲

-

💻 代码与版本控制:GitHub & JetBrains 深度集成

-

🌐 实时信息检索:Brave Search & Firecrawl 文档抓取

-

🛡️ 安全执行环境:Docker Sandbox 隔离运行

-

🧠 高级推理逻辑:Sequential Thinking 连续思考

-

⚙️ 配置实战:如何编辑

config.toml载入插件

1. 代码与版本控制 💻

作为编程指挥中心,版本管理是核心基石。

-

GitHub MCP:

-

能力:允许 Codex 自动提交 PR、审查 Issue、克隆仓库并执行代码分析。

-

推荐理由:这是 Agent 实现闭环开发最关键的“手脚”。

-

-

JetBrains MCP:

-

能力:连接你正在运行的 IDE(IntelliJ/PyCharm),实现编辑器状态与 Codex Agent 的实时同步。

-

命令示例:可通过

codex mcp add jetbrains快速接入。

-

2. 实时信息检索 🌐

AI 的知识库存在断层,而 MCP 提供了连接 2026 年最新文档的通道。

-

Brave Search MCP:

-

能力:提供无广告的清洁搜索结果,供 Agent 查阅最新的 API 变更。

-

-

Firecrawl / Jina Reader MCP:

-

能力:将复杂的网页内容转化为极简的 Markdown 格式,防止干扰 Agent 的长上下文(Context Window)。

-

3. 安全执行环境 🛡️

在让 AI 自动运行生成的代码前,安全隔离是必须的前提。

-

Docker MCP Toolkit:

-

能力:在受限的容器内执行代码,防止

rm -rf等误操作损坏你的主机系统。 -

关键配置:在 Codex 的

Agents.md中启用sandbox: true模式。

-

4. 高级推理逻辑 🧠

处理复杂架构设计时,普通的对话流容易迷失,需要结构化的思考。

-

Sequential Thinking MCP:

-

能力:强制 Agent 进入“多步推理 -> 反思 -> 修正”的逻辑链条,大幅降低处理上千行代码时的幻觉率。

-

5. 配置实战:编辑 config.toml ⚙️

OpenAI Codex 默认通过本地配置文件管理 MCP 服务器。

关键路径:~/.codex/config.toml (macOS/Linux) 或 %USERPROFILE%\.codex\config.toml (Windows)。

配置示例:

[[mcpServers]]

name = "github"

command = "npx"

args = ["-y", "@modelcontextprotocol/server-github"]

env = { GITHUB_PERSONAL_ACCESS_TOKEN = "你的Token" }

[[mcpServers]]

name = "brave-search"

command = "npx"

args = ["-y", "@modelcontextprotocol/server-brave-search"]

env = { BRAVE_API_KEY = "你的Key" }

提示:修改配置文件后,在 Codex 终端执行

codex reload即可生效,无需重启整个桌面应用。

总结

本文梳理了 2026 年初最适合 Codex 的 MCP 插件矩阵。GitHub 插件保证了操作权限,Brave Search 提供了最新知识,而 Docker 则筑起了安全防线。通过这些工具的组合,Codex 能从一个单纯的代码生成器进化为能够自主处理长周期任务的“AI 架构师”。

此外,实在Agent作为国产本土智能体平台,不仅适配各大主流应用和界面,还为用户封装好智能体开发、RPA等功能,让Agent具有动手能力,能够应用于企业高频复杂痛点场景,解决问题!

数据底座和数据中台的关系

智能体和大模型的关系

阿里千问红包怎么领?红包活动时间及领取方法